软件测试基础理论与人工智能时代下的算法软件开发实践

在当今以人工智能驱动的技术浪潮中,软件开发,特别是算法密集型软件的开发,正经历着深刻的变革。无论技术如何演进,扎实的软件测试基础理论依然是保障软件质量、提升交付效率的基石。本文旨在梳理软件测试的核心理论,并探讨其在人工智能算法软件开发背景下的应用与演进。

一、 软件测试基础理论核心

软件测试的根本目的是为了发现软件中存在的缺陷,并验证软件是否满足规定的需求,从而评估软件质量。其核心理论体系包括:

- 测试原则:如“测试显示缺陷的存在,而非其不存在”、“穷尽测试是不可能的”、“测试应尽早介入”等。这些原则是指导所有测试活动的哲学基础。

- 测试生命周期与流程:通常与软件开发模型(如瀑布、迭代、敏捷、DevOps)紧密集成。经典流程包括:需求分析、测试计划、测试设计、测试环境搭建、测试执行、缺陷跟踪与报告、测试评估与。

- 测试级别:从微观到宏观,确保软件各层次质量。

- 单元测试:针对软件最小可测试单元(如函数、类)进行,通常由开发人员完成。

- 集成测试:验证多个单元、模块或服务之间的接口与交互是否正确。

- 系统测试:在完整的集成系统上,验证其是否满足所有功能和非功能(性能、安全、兼容性等)需求。

- 验收测试:从用户或业务角度,确认软件是否准备好发布。

- 测试类型:根据测试目标的不同进行划分。

- 功能测试:验证软件功能是否符合需求规格说明。

- 非功能测试:包括性能测试、负载测试、压力测试、安全性测试、可用性测试等。

- 回归测试:确保新的修改没有破坏原有功能。

- 测试设计技术:

- 黑盒测试:基于需求规格,不关心内部实现,设计测试用例。常用技术有等价类划分、边界值分析、决策表、状态转换等。

- 白盒测试:基于代码内部逻辑结构设计用例,如语句覆盖、分支覆盖、路径覆盖等。

- 基于经验的测试:如探索性测试、错误推测法。

二、 人工智能算法软件开发的特点与测试挑战

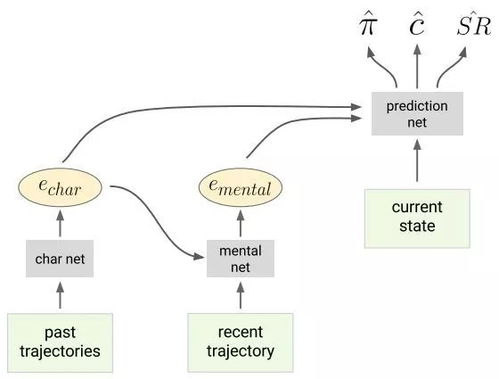

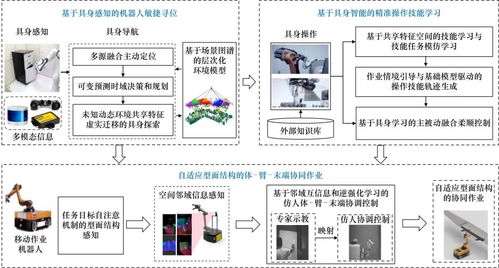

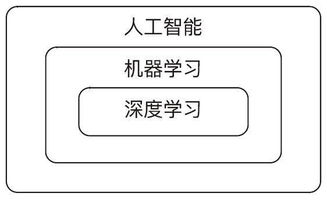

人工智能(AI)算法软件,尤其是基于机器学习和深度学习的系统,其开发模式与传统确定性软件有显著不同,这给测试带来了新挑战:

- 不确定性:AI模型的输出具有概率性和不确定性,相同的输入在不同条件下可能产生略有差异的输出,难以定义“正确”的绝对标准。

- 数据依赖性:模型的表现高度依赖于训练数据和测试数据的质量、代表性和分布。“垃圾进,垃圾出”是核心风险。测试不仅针对代码,更要针对数据。

- 动态演化性:模型会随着新数据的输入而持续学习更新,其行为可能随时间“漂移”,需要持续监控和测试。

- 可解释性差:复杂的深度学习模型如同“黑盒”,内部逻辑难以理解,使得传统白盒测试方法应用困难,故障根因定位复杂。

- 需求模糊性:业务需求可能被描述为“提高预测准确率”或“更好地识别模式”,而非具体的功能点,这使得验收标准量化困难。

三、 测试理论在AI算法开发中的适应与演进

面对上述挑战,软件测试基础理论并未过时,而是需要被扩展和重新诠释,以适应AI系统的特性:

- 测试重心的扩展:从代码到“数据+模型+代码”

- 数据测试:成为测试活动的首要环节。包括测试训练数据集的准确性、完整性、一致性、代表性、无偏性以及数据预处理流程的正确性。

- 模型测试:

- 离线评估:使用独立的验证集和测试集,通过精确率、召回率、F1分数、AUC-ROC等指标系统评估模型性能。

- 在线评估:通过A/B测试等方式,在真实生产环境中对比新旧模型的效果。

- 鲁棒性测试:测试模型对对抗性样本、输入噪声、数据分布微小变化的抵抗能力。

- 公平性与伦理测试:检测模型是否存在对不同群体的歧视性偏见。

- 测试设计技术的融合与创新

- 黑盒测试的深化:由于模型可解释性差,黑盒测试成为主要手段。需要为模型的“预期行为”定义可量化的、基于统计的验收标准(如“在测试集上的准确率不低于95%”)。

- 基于属性的测试:定义模型应满足的高级属性(如“单调性”、“稳定性”),并生成测试用例验证这些属性,而不拘泥于具体的输入-输出对。

- 变异测试的变体:对输入数据或模型本身进行有意“破坏”(变异),观察系统行为变化,评估测试套件的有效性。

- 测试流程的迭代与持续化

- MLOps中的持续测试:在MLOps(机器学习运维)流程中,测试需嵌入到数据流水线、模型训练流水线和部署流水线的每一个环节,实现自动化、持续化的测试与监控。

- 生产环境监控:部署后,持续监控模型性能指标、输入数据分布变化(概念漂移检测)、业务影响指标,建立反馈闭环,触发模型的重训练或回滚。

- 测试级别的重新定义

- 组件/单元测试:针对数据预处理函数、特征工程代码、损失函数、评估指标计算等确定性代码进行。

- 集成测试:测试数据流水线、训练流水线、模型服务API接口之间的集成。

- 系统/模型测试:将模型作为一个整体,在模拟或隔离的环境中,使用大量测试数据进行端到端的性能与功能验证。

- 验收/业务测试:通过A/B测试或影子模式,评估模型对最终业务目标(如点击率、转化率、用户满意度)的实际影响。

四、

人工智能算法软件的崛起,并未颠覆软件测试的基础理论,而是极大地丰富和拓展了其内涵与外延。测试工程师需要将传统的测试原则、级别、类型和设计技术与AI领域的独特需求相结合,构建一个覆盖“数据-模型-代码-基础设施”的全方位、持续化的质量保障体系。从验证确定性的逻辑,到评估概率性的性能;从测试静态的功能,到监控动态的演化,这要求测试人员不仅具备扎实的测试功底,还需理解机器学习的基本原理和数据处理知识。在这个智能时代,测试依然是,并且将更加是,确保软件可靠、可信、负责任地服务于社会的关键守护者。

如若转载,请注明出处:http://www.enstation-gz.com/product/50.html

更新时间:2026-02-25 05:52:29